보조수단 활용 가능성은 절반 이상…코드 분석은 20~30%

딥보이스 활용 피싱 주의…챗GPT 개인·기업정보 입력 주의

딥보이스 활용 피싱 주의…챗GPT 개인·기업정보 입력 주의

이미지 확대보기

이미지 확대보기SK쉴더스는 20일 서울 중구 을지로 SK T타워에서 '2023년 상반기 주요 보안 트렌드 및 AI 보안 위협 전망' 세미나를 열고 이 같이 밝혔다.

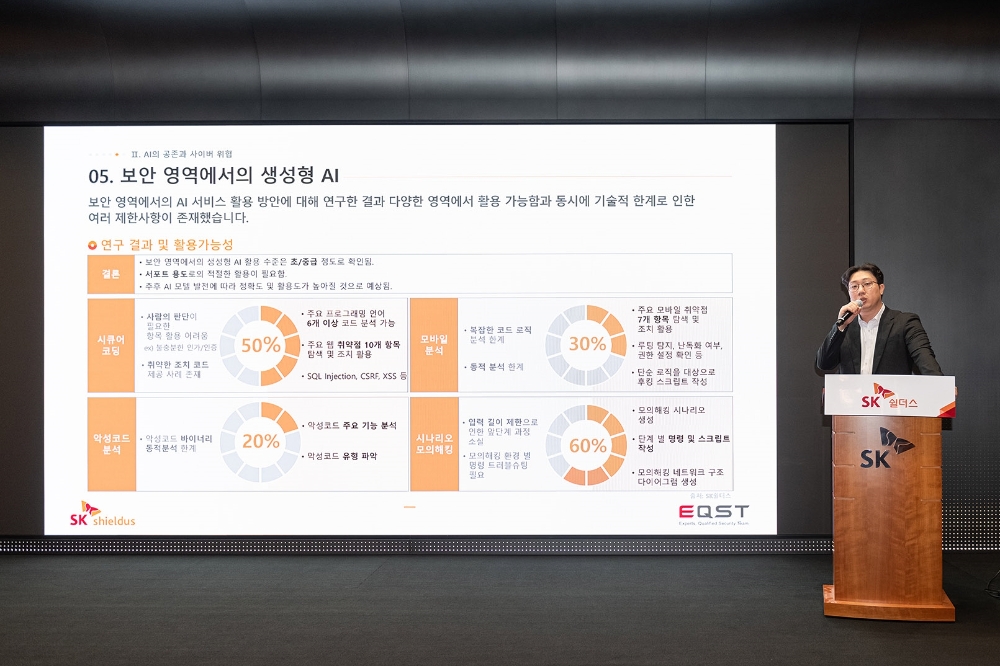

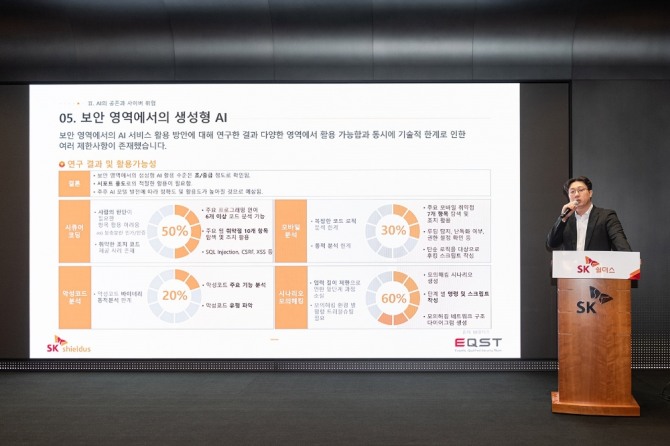

SK쉴더스에 따르면 생성형 AI를 활용할 수 있는 해킹분야를 4가지로 나눴을 때 '시큐어 코딩'과 '시나리오 모의 해킹'에서는 AI의 활용도가 각각 50%, 60%로 나타났다. 또 '모바일 해킹'과 '악성코드'에서는 각각 30%, 20%로 집계됐다.

이호석 SK쉴더스 EQST 랩장은 "코딩은 사람의 언어보다 규칙적이고 변수가 적기 때문에 활용 가능성이 높다"며 "다만 다양한 로직을 확인하지 못해 아직은 사람의 손을 거쳐야 한다. 만약 해킹에 쓰인다면 주요 수단으로는 활용되기 어렵고 보조수단으로 활용될 것"이라고 말했다.

생성형 AI를 활용한 해킹은 보조수단으로써는 활용 가능성을 보였지만, 모바일 해킹이나 악성코드 생성 등 직접적인 분야에서는 아직 낮은 수준의 활용도를 보였다. 이호석 랩장은 "루팅 탐지나 설정값 등 단순작업에서는 활용할 수 있다. 다만 해킹 특성상 복잡하고 긴 코드를 이해하는 것은 어렵다"고 말했다.

특히 모바일 해킹은 안드로이드 스마트폰의 경우 30% 정도의 가능성을 보였지만, 아이폰은 코드 자체를 볼 수가 없어 5~10% 정도의 해킹 가능성이 있다고 덧붙였다.

'악성코드' 분야에서는 생성형 AI가 연산능력은 뛰어나지만, 코드를 분석하는 것은 불가능하다고 설명했다. 특히 기계어로 변형할 경우 코드가 더 늘어나는 데 이를 조각으로 나눠 분석하는 게 어렵다.

이 밖에 SK쉴더스는 AI로 인한 직접적인 보안 위협으로 딥페이크와 딥보이스를 활용한 보이스피싱을 언급했다. 영상과 목소리를 합성해 전화로 상대를 속여 돈을 요구하는 방식이다. 이 같은 공격은 가상자산 탈취를 목적으로 하는 '로맨스 스캠'에도 활용되고 있다.

이호석 랩장은 "딥보이스 기술은 5초 분량의 목소리만 있으면 음성 합성이 가능하다"며 "다만 특정 단어에서 발음이 부정확하거나 말투가 어눌한 현상이 있다. 딥보이스 해킹에 대응하기 위한 연구는 현재도 활발히 진행되고 있다"고 밝혔다.

또 생성형 AI 사용에 따른 개인정보 유출도 주의해야 한다고 설명했다. 최근 챗GPT의 채팅 내용과 카드 사용 내역 등이 해킹돼 유럽 일부 국가에서는 서비스를 차단한 적도 있었다. 지난 4월 오픈AI가 프라이버시 보호 기능을 추가하면서 차단은 해제된 적이 있다.

그러나 챗GPT를 사용할 때는 개인정보를 입력하지 않도록 주의해야 한다고 이호석 랩장은 당부했다. 이호석 랩장은 "챗GPT는 채팅 내용이 서버에 저장돼 언제 어디서나 대화를 이어갈 수 있다. 즉 챗GPT에 적은 내용은 학습 데이터가 돼 언제든 유출될 수 있는 것"이라며 "기업에서도 챗GPT를 사용할 때 기업 내부자료를 입력하지 않도록 주의해야 한다"고 설명했다.

한편 SK쉴더스는 이날 상반기 보안 주요 트렌드로 △확장된 공급망 공격과 △대규모 랜섬웨어 공격 △가상자산 타겟 공격 등을 꼽았다. 또 상반기 공격 비율이 전년 상반기 대비 49.33%나 증가했으며, 기업의 기밀이나 개인의 금융 정보를 탈취하는 정보유출 침해사고가 30%로 가장 많이 발생했다고 밝혔다. 특히 올해는 오래된 취약점을 활용한 대규모 랜섬웨어 공격이나 제로데이를 악용한 악성코드 감염사고가 증가하며 28%를 차지했다.

여용준 글로벌이코노믹 기자 dd0930@g-enews.com