이미지 확대보기

이미지 확대보기삼성전자는 최근 AMD로부터 4세대 HBM인 ‘HBM3’와 첨단 패키징의 최종 품질 테스트를 통과했다.

서버용 중앙처리장치(CPU) 개발에 특화된 AMD는 대량의 데이터를 효율적으로 처리할 수 있는 칩 패키징과 머신러닝(기계학습) 기술을 사용하는 인공지능(AI) 가속기 사업을 확대하고 있다. AMD는 올해 4분기에 CPU, 그래픽 처리 장치(GPU)와 HBM3를 결합한 ‘MI300X’ 가속기를 출시할 계획이다.

‘MI300X’ 는 인공지능 (AI) 및 고성능 컴퓨팅(HPC) 분야에서 사용될 수 있다. 이 제품은 최대 80억 개의 매개변수를 가진 대규모 언어 모델을 직접 메모리에서 처리할 수 있는 '생성 AI 가속기’로 알려져 있다.

삼성전자는 HBM 제품과 함께 고급 패키징 솔루션을 제공할 수 있는 유일한 기업이다. AMD는 원래 TSMC의 패키징 서비스를 사용할 계획이었지만, TSMC의 고급 패키징 공급이 AMD의 수요를 충족하지 못하므로 계획을 변경했다. 삼성전자는 또한 엔비디아에도 HBM3와 패키징 서비스를 제공하기 위해 기술 검증을 진행하고 있다.

HBM(High Bandwidth Memory)은 '고대역폭 메모리'를 의미한다. 이는 데이터 처리 속도를 혁신적으로 끌어올린 제품으로, 여러 개의 D램을 수직으로 연결하여 만들어진다. HBM은 인공지능(AI) 시대의 필수재로 인식되면서 반도체 업계의 주도권 경쟁도 치열해지고 있다.

AMD의 ‘MI300X’와 엔비디아의 A100은 두 가지 다른 제품이다. AMD ‘MI300X’는 최대 192GB의 HBM3 메모리를 지원하며, 대형 언어 모델을 훈련하는 데 설계되었다. 이는 엔비디아의 A100보다 50% 더 많은 메모리 용량을 가지고 있다.

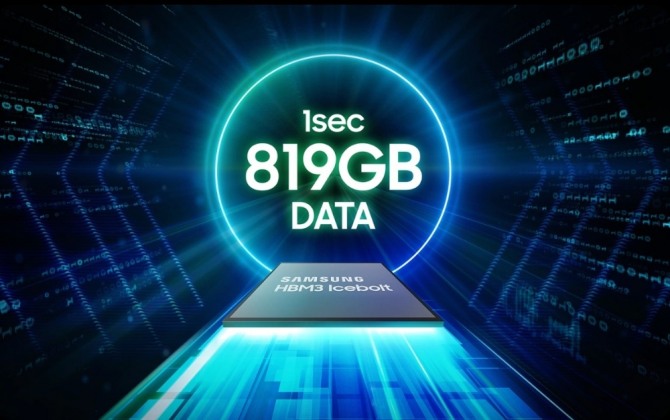

HBM3 메모리를 사용하는 다른 제품으로는 SK하이닉스의 HBM3 제품이 있다. 이 제품은 AI 및 HPC와 같은 용량 집약적인 응용 프로그램에 적합하며, 단일 큐브에서 최대 819GB/s의 대역폭을 제공할 수 있다.

삼성전자는 올해 하반기에 5세대 HBM 칩인 HBM3P를 출시하고, 내년에 현재 HBM 생산 능력과 고급 패키징 서비스를 2배 이상 늘릴 계획이다. 이 제품은 24GB의 용량을 기반으로 하며, 데이터 처리 속도를 혁신적으로 끌어올린 고성능 제품이다.

기술 시장 조사 업체인 트랜드포스에 따르면 삼성전자의 전 세계 HBM 시장 점유율은 현재 46~49%이며, 클라우드 서비스 제공 업체로부터의 새로운 주문으로 내년에 47~49%로 상승할 것으로 예상된다.

홍정화 글로벌이코노믹 기자 noja@g-enews.com

![[속보] 프란치스코 교황, 88세로 서거](https://nimage.g-enews.com/phpwas/restmb_setimgmake.php?w=80&h=60&m=1&simg=20250421171454020880c8c1c064d22114611240.jpg)