이미지 확대보기

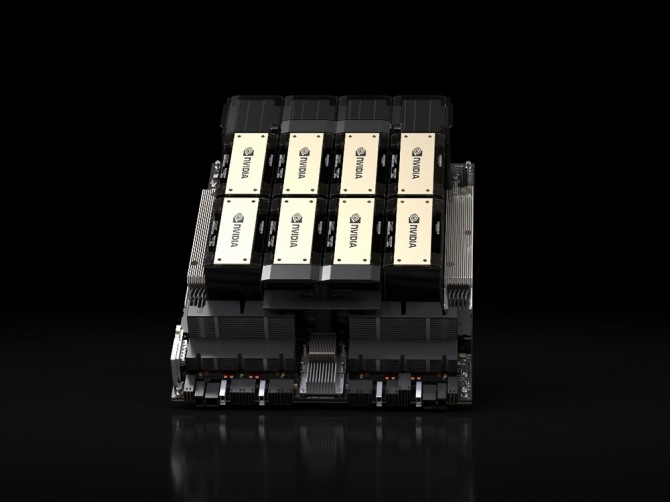

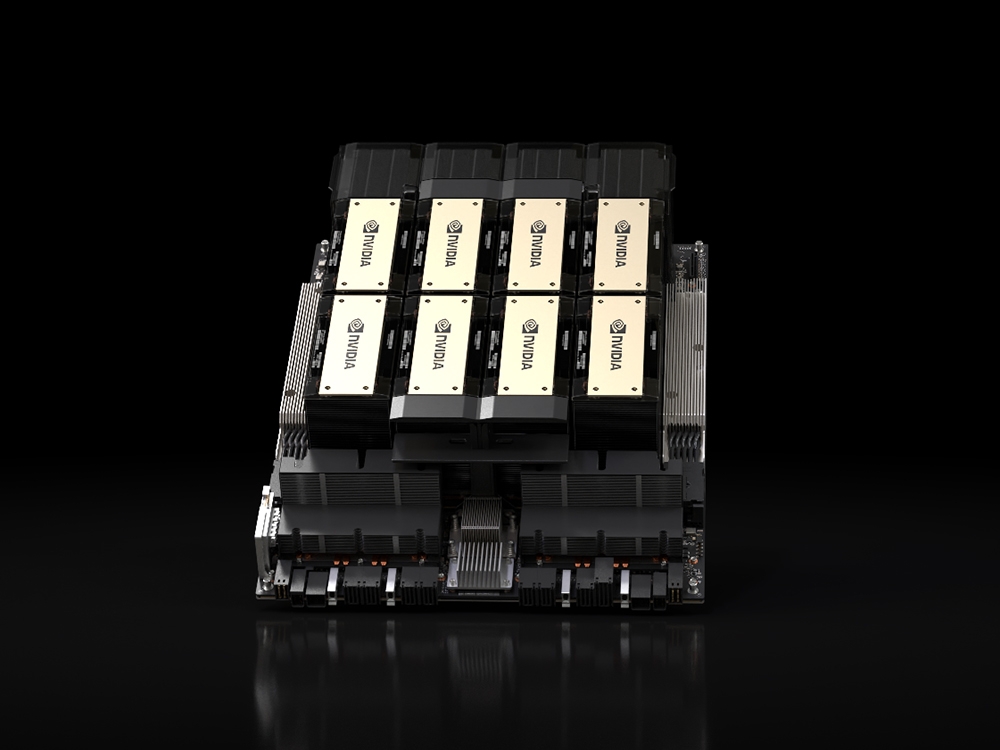

이미지 확대보기엔비디아에 따르면 신형 H200 GPU는 기존 H100 모델보다 대규모 언어 모델(LLM) 처리 속도가 최대 2배 더 빠르다. 엔비디아는 이 칩을 내년 2분기부터 고객들에게 공급할 예정이다. 하지만 2024년은 AI 시장에서 엔비디아 ‘독점’ 체제가 유지되기 어려울 전망이다. 다수의 브랜드가 경쟁하는 AI 반도체의 ‘군웅할거’ 시대가 열릴 전망이기 때문이다.

지난 15일에는 마이크로소프트(MS)도 자체 개발한 ‘애저 마이아 AI 가속기(Azure Maia AI Accelerator)’를 공개했다. 이 칩은 내년 초부터 MS의 데이터센터에 도입될 예정이다. 벌써부터 H200의 경쟁자가 즐비한 상황이다.

또한, LLM을 빠르고 효과적으로 훈련하려면 AI 서버를 최대한 많이 동원하는 것이 유리하다. 비슷한 비용으로 더 큰 규모의 AI 서버를 구축할 수 있다면 굳이 엔비디아 AI 칩만 고집할 이유가 없다.

이미 MS, 아마존, 구글 등의 클라우드 기업들은 엔비디아뿐 아니라 AMD 등 경쟁사 제품과 자체 개발 AI 칩까지 동원하며 다양한 종류의 AI 데이터센터를 동시다발적으로 구축하고 있다.

경제 전문지 배런스는 “MS의 마이아 칩은 LLM 교육 및 추론 등의 기능을 수행할 수 있으며, 이는 엔비디아 칩을 대체할 수 있다는 것을 의미한다”라며 “이는 MS가 엔비디아로부터 전면적인 전환을 고려한다는 의미는 아니지만, 자체 AI 칩을 보유하면 MS가 더 강력한 협상 위치를 확보하게 될 것이다”라고 지적했다.

이쯤 되면 AI 칩의 ‘성능’뿐 아니라 안정적인 공급 능력과 가격도 중요해진다.

올해 엔비디아 AI 칩은 수요가 급증하며 극심한 품귀현상을 빚었다. H100의 리드타임(제품을 주문하고 받기까지 걸리는 시간)은 1년까지 늘어났고, 가격도 공급가인 개당 약 2만 5000달러에서 약 4만 달러 이상으로 뛰었다. 네이버가 엔비디아 대신 인텔을 선택한 이유도 물량 부족+가격 상승 때문이다.

엔비디아 AI 칩을 제조하는 대만 TSMC가 생산량을 늘려도 지금의 밀린 수요를 모두 감당할 수 있을지는 의문이다. 경쟁사들은 이미 그 틈을 파고들어 점유율을 높이고 있다.

경쟁시장으로 바뀌면 엔비디아도 올해와 같은 배짱 장사를 하기가 어렵다. H100보다 2배의 성능을 내지만, 제조원가도 그만큼 비싼 H200을 그대로 2배 가격으로 판매할 수는 없다. 이는 장기적으로 엔비디아의 매출과 순이익에 영향을 미칠 수 있다.

물론, 엔비디아가 내년에도 AI 칩 1위 자리를 유지할 것은 분명하다. 다만 경쟁이 심화함에 따라 점유율은 올해보다 감소하고, 올해처럼 급격한 매출 및 순익 상승을 기대하기는 어려울 전망이다.

최용석 글로벌이코노믹 기자 rpch@g-enews.com

![[초점] 멕시코, 트럼프 관세폭탄 위협에도 “위기가 기회”](https://nimage.g-enews.com/phpwas/restmb_setimgmake.php?w=184&h=118&m=1&simg=20241229092651023649a1f3094311109215171.jpg)

![[초점] 전세계 10대 매출 기업…美 월마트, 12년 연속 1위](https://nimage.g-enews.com/phpwas/restmb_setimgmake.php?w=184&h=118&m=1&simg=20241229103201075549a1f3094311109215171.jpg)